“Nutzt Du schon ChatGPT?”

“Ja, furchtbar! Ich verstehe den Hype nicht. Das Ding liefert nur komische Antworten!”

In der aktuellen IT-Landschaft gibt es kaum ein Thema, das so präsent und diskutiert wird wie ChatGPT und ähnliche Technologien. Nahezu stündlich gibt es neue Berichte, die sich mit den Potenzialen und Grenzen künstlicher Intelligenz auseinandersetzen. In meinem Berufsleben stehe ich dieser Technologie sehr nahe und beschäftige mich bereits seit über fünf Jahren intensiv mit KI. Oft werde ich von Freunden und Bekannten gefragt, was es mit diesen Entwicklungen auf sich hat – sie haben davon gehört oder sogar schon eigene Erfahrungen damit gemacht. Deshalb möchte ich meine Perspektive und Erfahrungen teilen, um ein besseres Verständnis für diese Technologien zu vermitteln. Obwohl ich kein Informatiker bin und nicht direkt an der Entwicklung dieser Technologien beteiligt bin, bin ich doch eng mit den fachlichen Diskussionen und den sich eröffnenden Möglichkeiten verbunden.

Was GPT ist und was nicht

Zunächst vornweg: diese neuen Systeme sind nicht allwissend, können von Haus aus nicht Deine Steuererklärung machen und kennen auch nicht die Setlist Deiner Band beim letzten Gig anno 2018. Sie ersetzen auch (noch) nicht Suchmaschinen. Der Ansatz dieser sogenannten Large-Language Modelle fußt hauptsächlich auf der Vorhersage von Wahrscheinlichkeiten. Und damit sind wir auch schon mitten in der Frage: woher weiß GPT das alles?

Im Prinzip werden für diese relativ großen Modelle zunächst jede Menge Daten und Dokumente gesammelt. Diese stammen für ChatGPT wahrscheinlich aus allen frei zugänglichen Quellen, wie Wikipedia, Archiven, etc. Meist auf Englisch, seltener aus exotischeren Sprachen, doch dazu an anderer Stelle mehr.

Anschließend werden diese Daten mit verschiedenen statistischen Methoden verarbeitet und trainiert. Vereinfacht gesagt werden dabei Fragen gestellt und die Angaben entweder von einem menschlichen Gegenüber bewertet, oder das System sich selbst überlassen. Mit jeder Frage lernt das System dazu und die Trefferquote steigt. Um das vielleicht an einem Beispiel zu illustrieren:

“Ein Hund hat vier Beine.”

Das Modell: Hund 1,0; vier 1,0; Beine 1,0

“Ein Hund hat Fell.”

Das Modell: Hund 1,1; vier 1,0; Beine 1,0; Fell 1,0

“Ein Hund hat Fell an den Beinen.”

Das Modell: Hund 1,1; vier 1,0; Beine 1,1; Fell 1,1

“Ein Hund hat eine Schnauze.”

Das Modell: Hund 1,2; vier 1,0; Beine 1,1; Fell 1,1; Schnauze 1,0

“Ein Hund hat keinen Schnabel.”

Das Modell: Hund 1,3; vier 1,0; Beine 1,1; Fell 1,1; Schnauze 1,0; Schnabel -1,0

“Ist das ein Hund?”

Wo ist eigentlich Perry?

Eine mehrdimensionale Wolke aus Informationen

Jede Information wird auf diese Weise in ein System zu anderen Informationen gesetzt und formt dadurch eine Art Wolke mit vielen kleinen Wassertropfen. Der Vergleich hinkt etwas, da eine Wolke nur eine dreidimensionale Ausrichtung hat (Breite * Höhe * Tiefe), das LLM häufig aber über das hundert- bzw. tausendfache Merkmale verfügt:

Hund 127,5; vier 18,3; Beine 5,7; Fell 20,3; Schnauze 135,1; Schnabel -3,2; bellt 155,1 …

Bei diesem Ansatz formen sich enge Beziehungsgeflechte ähnlicher Worte, die zueinander in Beziehung stehen. Je größer der Zusammenhang ist, desto näher befinden sich die Begriffe zueinander.

Was nützt mir das?

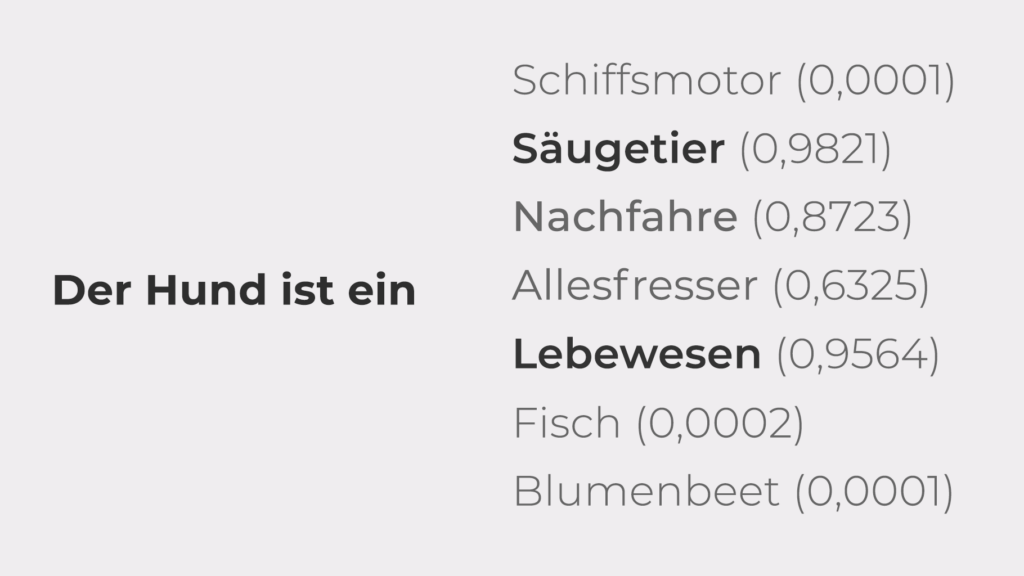

Der Witz an dieser Sache ist, dass dieses Modell Wahrscheinlichkeiten erfassen kann, wie eine Antwort auf eine Frage aussieht. Dabei wird zunächst die Frage in die Bestandteile zerlegt. Aus:

Frage: “Sind Hunde fleischfressende Säugetiere?”

extrahiert das Modell:

Hund, Mehrzahl, Fleisch, fressen, Säugetiere

Die Antwort erfolgt dann nach Wahrscheinlichkeiten:

Deshalb erinnert die Antwortgenerierung bei ChatGPT auch immer etwas an eine Schreibmaschine. Jedes Wort ist wohlüberlegt und wird statistisch abgewogen.

Ist ChatGPT doof?

Nein, natürlich nicht. Aber es kann z.B. keine Mathematik, da es nicht auf mathematische Zusammenhänge, sondern auf Texte trainiert wurde. Diese Texte stammen alle aus Trainingsdaten von April 2023 und sind mehr oder weniger genau. Auch wenn der Gig Deiner Band vielleicht vor dem Datum lag, ist die Gesamtinfo statistisch zu klein oder vielleicht gar nicht im Modell vorhanden.

Allerdings kann diese Vorhersage der LLMs beispielsweise genutzt werden, um sich Programme schreiben zu lassen, ohne dass man selbst programmieren kann oder die Programmiersprache versteht. Wie das geht, zeige ich in einem anderen Beitrag.